Wer verwendet Ryte?

Von Freiberuflern bis zu Agenturen und Unternehmen profitieren von Ryte.

Was ist Ryte?

Das Münchener Startup-Unternehmen mit dem früheren Namen onpage.org bietet eine Software für ganzheitliches Monitoring, Analysieren und Optimieren. Im Vordergrund steht bei diesem SEO-Tool die OnPage-Optimierung. Seit kurzem gibt es auch eine Keywordranking-Optimierung.

Ryte unterteilt in zwei Arten der Analyse. Die Einzelanalyse einer Seite und die Komplettanalyse der gesamten Website.

Ryte besteht aus drei Modulen:

- Website Success: Hier erfolgt die klassische OnPage-Optimierung. Sowohl technische als auch inhaltliche Fehler werden aufgezeigt. Analysemöglichkeiten von relevanten SEO-Faktoren plus Tipps zur Verbesserung stehen ebenfalls zur Verfügung. Es sind ausführliche Auswertungen zu Content, Links und Ladezeiten möglich. Außerdem lassen sich die Indexierbarkeit der Seiten, die Qualität des Contents, der Performance und der URL-Struktur gut darstellen und es werden Hinweise auf Optimierungspotentiale angezeigt.

- Search Success: Dieses Modul bezieht sich auf den OffPage-Bereich der Website. Die Analyse ist auf

Google ausgerichtet. Keywords werden im Google Ranking untersucht. Ein Vergleich der eigenen Website mit Wettbewerben ist gut möglich. Insgesamt aber etwas oberflächlich im Vergleich zu anderen Tools und deshalb keine Alternative, wenn es dem Betreiber darauf besonders ankommt. - Content Success: Hier erfolgt die WDF*IDF-Analyse. Einzelne Seiten werden optimal auf ihre Keywords analysiert. Ein Textassistent gibt dabei wertvolle Tipps, zum Beispiel welcher Begriff zu oft verwendet wurde.

Ryte Bewertungen / Erfahrungen

Diese Ryte-Bewertungen werden automatisch aus 10 eingereichten Nutzer-Erfahrungen ermittelt.

Ryte Rezensionen

„Ryte ist ein sehr mächtiges SEO-Tool!“

Vorteile von RyteRyte ist extrem umfangreich und ein sehr mächtiges Tool. Trotzdem schafft es, Nutzern einen Überblick zu verschaffen, wo die größten Baustellen auf der eigenen Website sind – sowohl auf die zugrundeliegende Technik bezogen als auch auf den Content. Der Support ist herausragend.

Nachteile von RyteRyte ist relativ teuer – insbesondere wenn man das Online-Marketing gerade erst aufbaut, bezahlt man für viele sehr kleinteilige Features mit, die man (noch) nicht braucht.

Beste Funktionen von RyteFür umfangreiche SEO ist der Bereich Search Success super. Aktuell freue ich mich hier immer über den noch jungen Newsfeed, der mir mitteilt, welche Keywords Google gerade testet.

Allgemeines Fazit zu RyteIch bin sehr zufrieden.

„Super Tool zum Bewerten von Onpage Faktoren.“

Vorteile von RyteGute Übersicht über Probleme auf der eigenen Seite.

Nachteile von RyteTeilweise etwas unübersichtlich.

Beste Funktionen von RyteWebsite Success

Allgemeines Fazit zu RyteGuter Allrounder mit vielen Möglichkeiten.

„Allumfassende SEO Funktionen und eine schöne Aufmachung der Daten.“

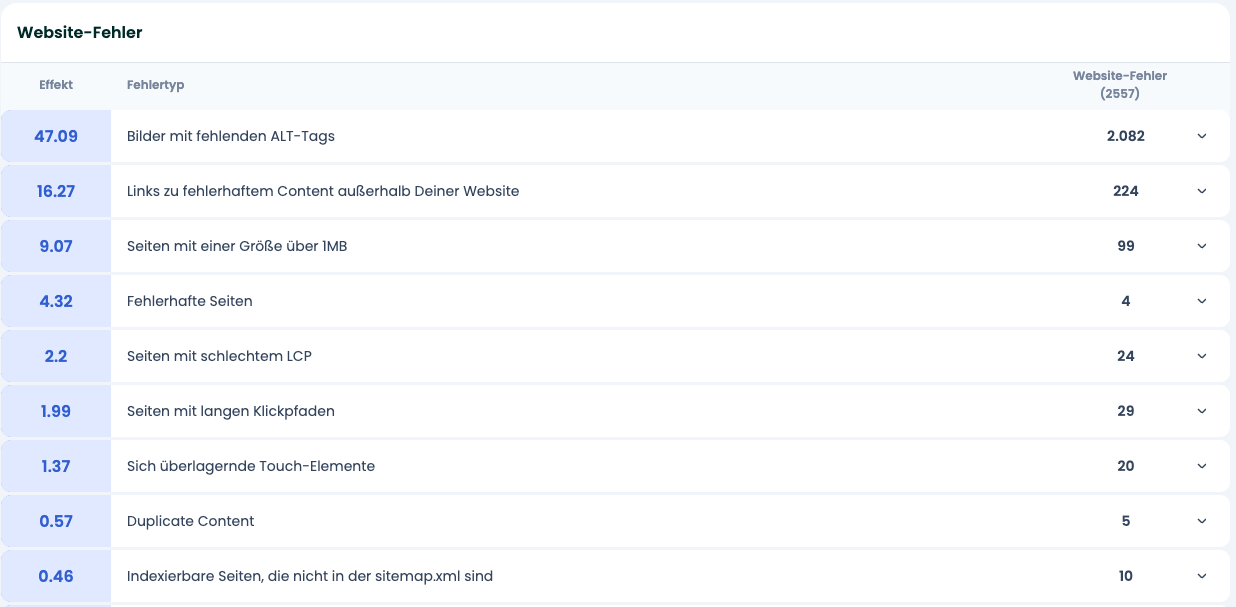

Vorteile von RyteRyte deckt alle wichtigen Faktoren für eine suchmaschinenfreundliche und technisch korrekte Website ab. Besonders positiv sind die Übersichten aller Website-Fehler zu werten die auch schnell an Kunden weitergegeben werden können. Die Filterfunktionen für die detaillierte Datenauswertung funktionieren sehr gut und ermöglichen konkretere Auswertungen. Insgesamt eines meiner meistgenutzten Tools, da es technisch alles abdeckt. Der Support ist super freundlich und man pflegt ein gutes Verhältnis zum Ryte-Team.

Nachteile von RyteEin Account Upgrade ist kostentechnisch ein recht hoher Sprung nach oben. Es braucht auf jeden Fall Zeit als neuer Tool-Anwender vollständig alle Möglichkeiten erkunden und verstehen zu können. Allerdings helfen hierbei auch die unzähligen Ryte Webinare.

Beste Funktionen von RyteWebsite Success: Fehler Reports nach Prioritäten sortiert mit dazugehörigen Detail-Analysen.

Allgemeines Fazit zu RyteMein liebstes Tool für technisches SEO. Das Tool entwickelt sich immer weiter und hat alles, was man für eine Websiteoptimierung benötigt.

„Ryte get’s you the right direction.“

Vorteile von RyteIch arbeite seit vielen Jahren mit Ryte (ehemals onpage.org) und bin nach wie vor sehr zufrieden. Ich arbeite nahezu täglich damit. Was als Technical SEO Tool begann ist mittlerweile eine fast vollständige Online Marketing Suite die sich sehen lässt. Ich verwende das Tool hauptsächlich für die technische Suchmaschinenoptimierung, aber auch für Content Optimierung. Ryte ist einfach eine Waffe.

Hervorzuheben ist vor allem auch der Support, der bei Ryte wirklich herausragend ist. Immer verfügbar, schnelle Antworten, technisches Know-How. Sehr stark!

Das Tool ist nach wie vor ein mächtiges SEO Tool. Ich finde aber, man hat in den letzten Jahren den SEO-Fokus etwas verloren.

Beste Funktionen von Ryte- Website Success

- Content Success

Ryte ist eine wahre Online Marketing und Web Dev Waffe. Absolute Empfehlung.

„Das Tool für SEO-Profis.“

Vorteile von Ryte- Search Success: Übersichtliche Auswertung der Daten von Google Search Console

- Website Success: sehr detaillierte technische Analyse mit Verbesserungsvorschlägen für die Entwickler

- der persönliche Support, vor allem in den großen Paketen, ist unerreicht. Wer einmal mit Marcus Tandler eine halbstündige “Session” hatte, kann viel lernen.

- Es wird manchmal zu kleinteilig, wichtige Aufgaben werden nicht klar priorisiert, man verliert sich in eher unwichtigen Details, was für Einsteiger eine große Hürde ist.

- Ryte ist manchmal ein bisschen zu “salesy”. Einmal angemeldet, wird man regelmäßig kontaktiert von den Vertrieblern.

- Man braucht sehr viel Zeit, sich in Ryte einzuarbeiten.

Search Success

Allgemeines Fazit zu RyteEines der besten Onpage-Tools auf dem Markt, aber so mächtig, dass man viel Zeit mitbringen muss, sich einzuarbeiten und die Datenmenge richtig zu interpretieren.

„Das Tool für das Website Quality Management!“

Vorteile von Ryte– sehr übersichtlich

– einfach zu bedienen

– viele wichtige Website Quality Daten

– im Verhältnis zu anderen Tools in der Business Suite sehr teuer

– keine Möglichkeit einen Report zusammenzustellen

– Website Success (OnPage Optimierung)

– Search Success (Keyword Alerts / Monitoring)

Wer sich für den stolzen Preis das Tool leisten kann /will, der bekommt mit Ryte ein sehr gutes und benutzerfreundliches Tool zum Monitoren und Optimieren von internen Projekten und Kundenwebsites.

Lukas Haemisch

Online Marketing Manager

TravelWorks

„Der tägliche Begleiter auf dem Weg zur optimierten Webseite“

Vorteile von RyteRyte´s Website Success hilft uns ungemein die Performance unserer Seite im Auge zu behalten. Ohne dieses Tool wären wir nicht in der Lage alle Seiten in dieser Form zu überwachen. Es zeigt uns auf sehr bequeme Weise, wo Fehler entstehen oder allgemein Handlungsbedarf besteht und liefert im Zweifel über die Wissensdatenbank auch das passende Know-how für SEO-Einsteiger.

Search Success reichert die Daten aus Googles Search Console an und ermöglicht es und die Menge an Daten deutlich bequemer zu verwalten.

Mit Content Success haben unsere Redakteure ein simples Tool zur Bewertung Ihrer Texte nach WDF*IDF.

Nachteile von RyteDer enorme Umfang des Tools setzt etwas Erfahrung und Wissen voraus. Man muss schon wissen, wie die Daten interpretiert werden können. Insbesondere bei großen Seiten verliert man sich schnell in Daten.

Beste Funktionen von RyteWebsite Success ist ein täglicher Begleiter zur Verbesserung unserer Seite.

Allgemeines Fazit zu RyteRyte bietet sehr viel Unterstützung bei der täglichen Suchmaschinenoptimierung und erleichtert bei guter Organisation die Arbeit mit den Daten aus der GSC. Kommt man mal nicht weiter, hilft das Support-Team schnell und kompetent weiter. Darüber hinaus bietet Ryte jede Menge ergänzenden Content, der Einsteigern das Thema nahebringt.

„Ein super umfangreiches Tool mit tollem Preis-/Leistungsverhältnis“

Vorteile von RyteRyte ist ein sehr umfangreiches Tool, das durch eigenes Crawling sowie die Schnittstellen zur Google Search Console und Google Analytics umfangreiche Fehleranalyse ermöglicht. So können mit wenig Zeitaufwand viele Verbesserungspotenziale erkannt werden.

Sehr benutzerfreundlich ist auch der OPR-Wert, welcher eine Idee vom Linkjuice einzelner Seiten vermittelt und das relativ neue Feature „BotLogs“, welches auch ohne IT-Kenntnisse Logfile-Analysen möglich macht.

Besonders gut gefällt mir weiterhin die Internationalität, die wir z.B. bei TF*IDF Analysen wirklich brauchen und von wenigen anderen Tools so abgedeckt wird.

Der Vorteil des Umfangs ist gleichzeitig hier und da auch ein Nachteil. Das Tool neigt dazu, einen mit Informationen zu „erschlagen“. Eher nebensächliche, weniger wichtige Fehler, die sich auf einer größeren Webseite häufig nicht vermeiden lassen, wirken deutlich dramatischer als sie wirklich sind.

Auch ist die TF*IDF Analyse bei Ryte m. E. nicht so gut wie bei bspw. TermLabs.io. Hier tut sich Ryte schwer, zwischen relevanten und irrelevanten (Füll-)Wörtern zu unterscheiden.

Website Success mit Fehleranalyse

Allgemeines Fazit zu RyteRyte ist ein sehr umfangreiches Tool, das vielen SEOs die Arbeit erleichtern kann. Bei der Priorisierung von Aufgaben braucht es allerdings etwas SEO-Erfahrung. Nicht jede Fehlerkorrektur wird zu einer Ranking-Verbesserung führen. Man muss also aufpassen, sich nicht zu „verzetteln“ und das Wesentliche (Content und Links) nicht aus dem Blick zu verlieren.

Auch Features wie die „TF*IDF“ Analyse können nur mit wachem Verstand genutzt werden.

„Umfangreiches, günstiges Tool für fortgeschrittene Onliner um die Technik auf der eigenen Seite aus SEO Sicht in den Griff zu bekommen und um an der Keyword- & Contentstrategie zu arbeiten.“

Vorteile von RyteDer primäre Vorteil ist sicherlich der gewaltige Leistungsumfang gepaart mit zahlreichen Möglichkeiten der Filterung und Anpassung. Trotz dieser Flexibilität ist die Usability noch immer sehr hoch.

Nachteile von RyteMan muss sich im Thema schon sehr gut auskennen, um die richtigen Filter zu setzen und relevante Daten zu erhalten. Für Anfänger ist der Mehrwert unserer Meinung nach überschaubar. Da gibt es Tools die wesentlich mehr vereinfachen und die ToDos auf verständliche Aktionen runter brechen. Aber das ist ja nicht die primäre Zielgruppe von Ryte.

Teilweise ist das Tool recht langsam, was verständlich ist – suggeriert wird aber ein on-the-fly Erlebnis.

Den OnPage Score, da es gut tut wenn man sieht wie dieser immer weiter steigt – ist gut für die Motivation 🙂

Allgemeines Fazit zu RyteWir nutzten das Tool von dessen Start an, damals noch OnPage.org genannt. Für den regelmäßigen Check seiner Projekte ist es wunderbar geeignet und für kleine Seiten sicherlich auch als primäres Optimierungstool einsetzbar. Bei großen Seiten und Web-Shops muss man seine Entscheidungsbasis dann schon noch um Daten aus anderen Quellen ergänzen.

Als kleiner Kunde hat man hin und wieder etwas Probleme mit dem Support, aber mit geduldigem erklären und dranbleiben bekommt man schlussendlich schon die Hilfe die man braucht 😉

„All-Ryte – wenn man die für sich relevanten Spiel- und Informations-Ebenen im Blick hat, kann man jede Woche an der Entwicklung der Seite arbeiten, bis “Alles” richtig ist!“

Vorteile von RyteSchneller Überblick und guter Einstieg auch für Mitarbeiter, die das Tool noch gar nicht kennen. Die Hauptbereiche im Standard-Package (Website, Content, SEO) sind schnell erfassbar. Man kann mit Filtern in den Details je nach Projektfortschritt und Priorität auch in den Details gezielt abarbeiten. Einzelseiten-Analyse hilft beim schnellen Blick “unter die Haube” (auch bei neuen Projekten oder in der Angebotsphase).

Nachteile von RyteEinige der vielen Details sind in der Navigation nicht immer 100% intuitiv zu finden, das fällt vor allem dort auf, wenn man nach etwas längerer Zeit in einen weniger genutzten Bereich einsteigen will oder muss.

Beste Funktionen von RyteSchneller Überblick schon in den Statusmails und (Kritische) Fehler nach Priorität gefiltert abarbeiten.

Allgemeines Fazit zu RyteDas Tool ist mächtig und hat sich auch inhaltlich von “OnPage” zu “All-Ryte” entwickelt. Schon die “Basis” ist mächtig genug um sowohl SEO-Technik, wie auch Content laufend und gut optmieren und aufbauen zu können. Die Status-Updates helfen die Gesundheit (“Health-Status”) der Projekte im Blick zu haben und bei Bedarf in den Details Fine-Tuning zu machen.

Autor: Heiko Höhn

Professionelle Suchmaschinenoptimierung (SEO) dank Ryte

Professionelle Suchmaschinenoptimierung (SEO) dank Ryte

Statistisch gesehen klickt sich kaum ein Google-Nutzer bei seiner Treffer-Suche bis zur zweiten Ergebnis-Seite durch, sondern bedient sich überwiegend an den Resultaten auf Seite 1 (Quelle: AuthorityHacker, Studie vom 25. März 2020 https://www.authorityhacker.com/million-serps-analyzed). Umso wichtiger ist es also, dass die eigene Online-Präsenz bereits unter den ersten Suchergebnissen vertreten ist und somit mühelos gefunden werden kann.

Was ist Ryte?

Um dies zu verwirklichen, greift einem hierzu die aus München stammende Software „Ryte“ unter die Arme, welche dem ein oder anderen sicherlich noch als OnPage.org bekannt sein dürfte. Bei dieser handelt es sich sowohl um ein SEO-, als auch um ein Content-Tool, mit welchem man sich dank zahlreicher Features sowohl einen schnellen Kurzüberblick über die Qualität des eigenen Projektes verschaffen, als auch umfangreiche Analysen durchführen kann. Es prüft die Webseite auf Herz und Nieren, um möglichen Fehlern auf den Grund zu gehen und seinen Online-Auftritt somit effektiv zu verbessern.

Ryte ist um weitere SEO Reports gewachsen

WUX Übersicht

- Bilder mit fehlenden ALT-Tags

- Links zu fehlerhaftem Content

- Seiten mit einer Größe über 1MB

- Duplicate Content

- Indexierbare Seiten, die nicht in der sitemap.xml sind

- Duplicate H1 Tags

Check auf Barrierefreiheit

Im Toolabschnitt Barrierefreiheit werden folgende Punkte genauer analysiert.

- Report: Alt-Attribute

Anhand einer Liste der Bilder der Website, einschließlich der URLs, auf denen sie sich befinden, werden die hinterlegten ALT-Tags und eine Bildvorschau ermittelt. Im Report werden fehlende Alt-Tags ermittelt. Für das Projekt kann eine Übersicht erstellt werden, um den Bildinhalt als Alternativtext zu ergänzen.

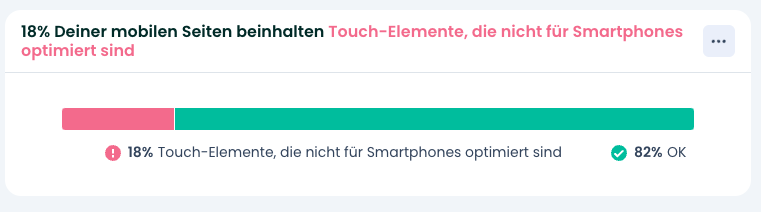

- Report: Sich überlagernde Touch-Elemente

Touch-Elemente sind die Bereiche einer Webseite, mit denen Benutzer auf Touch-Geräten interagieren können. Schaltflächen, Links und Formularelemente haben Touch-Elemente.

Sich überlagernde Touch-Elemente sind Elemente, die auf mobilen Geräten mit Touch-Funktionalität (Smartphone oder Tablet) zu nahe beieinander liegen, so dass der User sie möglicherweise nicht antippen kann, ohne versehentlich auf das falsche Element zu kommen.

Suchmaschinen bewerten Seiten danach, wie mobilfreundlich die Zielseiten sind. Durch das Tool soll sichergestellt werden, dass die Schaltflächen groß genug und weit genug voneinander entfernt sind.

- Report: Fehlende Viewport-Tags

Viele Suchmaschinen stufen Seiten danach ein, wie mobilfreundlich die Zielseiten sind. Ohne ein Viewport-Meta-Tag werden Seiten auf mobilen Geräten in der typischen Desktop-Bildschirmbreite dargestellt und dann verkleinert. Dadurch werden diese schwer lesbar. Durch das Setzen des Viewport-Meta-Tags kann die Breite und Skalierung des Ansichtsfensters gesteuert werden, sodass es auf allen Geräten die richtige Größe hat.

- Report: Nicht lesbarer Text auf mobilen Seiten

Dieser Report zeigt Seiten, auf denen 40 % oder mehr des Textes eine Schriftgröße von weniger als 12 Pixel haben. Diese Pixelgröße ist auf mobilen Geräten zu klein in der Darstellung.

The Ryte way to your digital success

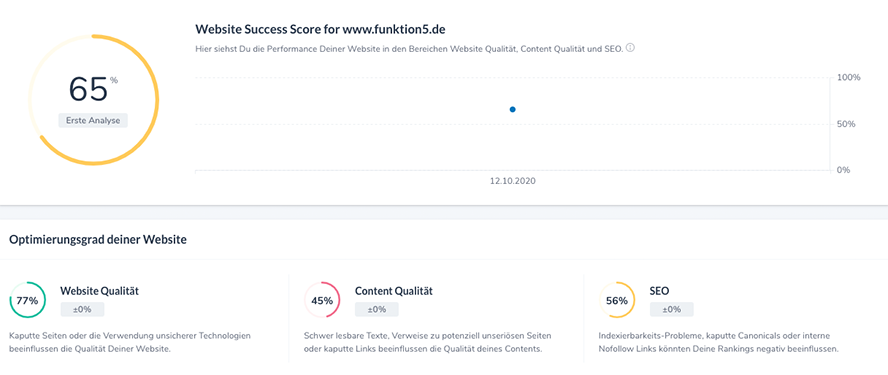

In meinem Test widme ich mich unserer firmeneigenen Webseite www.funktion5.de. Nach Anlage des Projektes offenbart einem die Ryte Suite die folgenden drei, grundlegenden Tools, dessen Daten zunächst einmal auf dem Dashboard dargestellt werden:

Website Success:

Hinter diesem Modul verbirgt sich die technische und inhaltliche OnPage-Optimierung. Mit dessen Hilfe lassen sich versteckte Fehler nicht nur entdecken, sondern sogar nach ihrer Relevanz bewerten, um diese dann anschließend in einer sinnvollen Reihenfolge zu beseitigen. Beispiele hierfür sind fehlende Bildbeschreibungen, kaputte Links oder doppelte Inhalte, welche sich allesamt negativ auf die prozentuale Bewertung von Ryte und natürlich auch auf die tatsächliche Auffindbarkeit der eigenen Webseite auswirken.

Über die Analyse kann eine erste Bestandsaufnahme vorgenommen werden, ob kritische Fehler behoben werden sollten. Tatsächlich ist unsere Seite von keinem einzigen, kritischen Fehler betroffen, andernfalls hätte Ryte uns aber direkt eine Möglichkeit genannt, um diesen zu beheben. Super!

Praktischerweise kann man sich sogar einen Überblick über eventuelle Einbrüche der Server-Erreichbarkeit verschaffen, welche in der Vergangenheit zu Problemen geführt haben könnten.

Eine genaue Aufzählung aller Funktionen lautet:

- Übersicht

- Hier erhält der Nutzer eine übersichtliche Darstellung der erkannten Probleme und des allgemeinen Zustandes seiner Webseite.

- Kritische Fehler

- Nach der Einrichtung von Ryte sollte man sich als allererstes diesen Punkt ins Visier nehmen, da dieser ausschlaggebend für eine gut besuchte Webseite ist. An dieser Stelle werden die kritischen Fehler angezeigt, damit sie schnellstmöglich behoben werden können. Beispiele hierfür sind 404-Links oder sogar 5XX-Serverfehler, welche ein absolutes No-Go für eine erfolgreiche Seite sind. Wie oben bereits erwähnt bleibt unsere von diesen Fehlern aber verschont, sodass wir uns bereits nach kurzer Zeit dem nächsten Punkt widmen konnten.

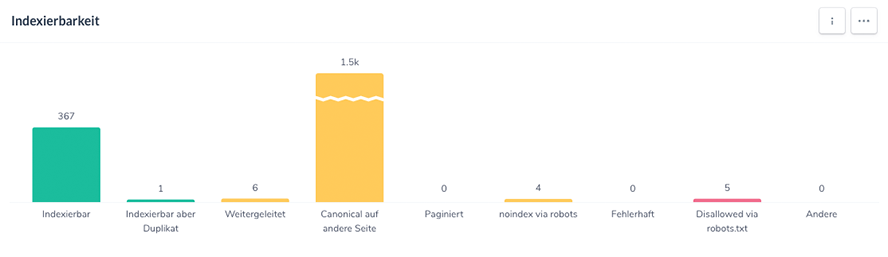

- Indexierbarkeit

- Mit dieser Funktion lässt sich prüfen, welche Seiten von Google indexiert werden, bei welchen dies durch die robots.txt-Datei verhindert wird und wo hierbei Probleme auftreten. Zudem lassen sich sämtliche Weiterleitungen (Status Code 301) einsehen. In unserem Fall indexiert Google 368 Seiten, wobei eine davon ein Duplikat ist. Zudem haben wir die Indexierbarkeit von insgesamt 5 Seiten in der robots.txt-Datei untersagt.

- Inhalt

- Unter diesem Punkt werden erste Analysen zum Inhalt durchgeführt. Beispielsweise werden Titel, Beschreibungen und Überschriften auf ihre Länge geprüft, damit diese ggf. gekürzt werden können. Berücksichtigt wird dabei auch die verkleinerte Ansicht auf Mobilgeräten, für welche möglichst kurz gehaltene Überschriften besonders wichtig sind. Zudem lässt sich sicherstellen, ob die Meta-Title und Meta-Descriptions jeder Seite gepflegt sind.

- Dateien

- Hier können sowohl die eingesetzten CSS-Dateien, als auch die Erreichbarkeiten der einzelnen Bilder, sowie womöglich vergessene Alt-Texte geprüft werden. In unserem Test antworteten die Header sämtlicher Bild-URLs mit 200, sodass wir eine vollständige Verfügbarkeit aller Bilder feststellen konnten.

- Mehrsprachigkeit

- Wenn Google nicht in der Lage ist, die Sprache einer Zielseite eindeutig zu ermitteln, ist dessen Zuordnung zu einem Land oder einer bestimmten Sprache nur schwer möglich. So könnte es sein, dass mehrere, identische Versionen einer Einzelseite in unterschiedlichen Sprachen indexiert werden. Dies kann in der Praxis schnell zu einer negativen User Experience führen, weil die Nutzer von google.de sehr wahrscheinlich deutschsprachige Webseiten in den Suchergebnissen erwarten.

Falls man seine Seite also mehrsprachig aufgebaut und einzelne Übersetzungen angelegt hat, lassen sich diese hier prüfen. Auf funktion5.de beschränken wir uns jedoch lediglich auf Deutsch.

- Links

- Durch einen Klick auf diesen Punkt lassen sich zum Beispiel kaputte Links als solche identifizieren, Seiten ohne eingehende Links aufspüren und die Link-Ziele prüfen. Außerdem lässt sich überprüfen, ob es URLs gibt, die überdurchschnittlich lange Klickwege erfordern, um von einem Nutzer erreicht zu werden.

- Sitemap

- Dieser Menüpunkt gewährt dem Nutzer Einsicht in die Sitemap. Es lässt sich sowohl prüfen, welche Seiten dieser hinterlegt sind, als auch gegenteilig, welche dieser fehlen. Zudem lassen sich sämtliche Änderungen an dieser nachvollziehen.

- Performance

- Sofern einem die eigene Seiten-Performance in der Vergangenheit negativ aufgefallen sein sollte, lassen sich die möglichen Ursachen unter diesem Tab bestimmen. Neben den Ladezeiten und der Kompression werden außerdem noch die Größen einzelner Dateien berücksichtigt, da sich diese ebenfalls negativ auf die Performance auswirken können. In der Kategorie „Schnell“ erzielt unsere Seite die maximale Quote von 100 %, sodass wir keinerlei Performance-Probleme verzeichnen können.

- URL Struktur

- Wie der Titel es vermuten lässt, fokussiert man sich an dieser Stelle auf die Struktur der einzelnen URLs. Hierbei beschränkt sich das Tool nicht nur auf das Kürzen von zu langen URLs, sondern ist außerdem in der Lage, Großbuchstaben und Sonderzeichen aufzuspüren.

- Google Analytics

- Ryte bietet seinen Nutzern die Möglichkeit, das eigene Google Analytics Konto und die eigene Search Console mit sich zu verknüpfen, wodurch die Betrachtung des Traffics pro URL gesichert ist. Somit ermöglicht Ryte eine noch tiefere SEO-Datenanalyse mit Hilfe von Webanalysedaten und echten Rankingdaten aus der Google Search Console. Pro URL lassen sich die folgenden Daten auswerten:

-

-

-

- Traffic der letzten 30 Tage pro URL und der Vergleich mit 30 Tagen davor

- Pageviews

- Durchschn. Besuchszeit

- Absprungrate

- Seitenaufrufe

-

-

- Single Page Analysis

- Sofern man einen möglichen Rankingverlust einer einzelnen Seite bemerkt hat, lässt sich mit dieser Funktion jede beliebige Einzelseite durch Eingabe der entsprechenden URL analysieren und optimieren. So ist es zum Beispiel sinnvoll, Descriptions zu ergänzen, Titel zu kürzen und/oder ein Favicon hinzuzufügen, je nachdem, welche Probleme Ryte erkennt.

- Server Monitoring

- In Form eines stets aktuellen Diagrammes lassen sich an dieser Stelle die Ping-Werte bzw. die Erreichbarkeiten des Servers abrufen, auf welchem die Seite stationiert ist. Des Weiteren wird diese außerdem noch prozentual angegeben und eventuelle Vorkommnisse werden zuverlässig dokumentiert.

- txt Monitoring

- Zu guter Letzt lassen sich über diesen Punkt sämtliche Änderungen an der robots.txt-Datei nachvollziehen, welche eventuell dazu führen könnten, dass einige Seiten von Google nicht mehr indexierbar sind.

Content Success:

Ein mindestens genauso wichtiger Faktor für erfolgreiche Seiten-Rankings ist der Inhalt. Mit der sogenannten TF*IDF-Analyse hilft dieses Tool bei der Erstellung von überzeugenden Website-Inhalten und der Abstimmung der Keywords auf alle einzelnen Seiten.

Mittels der Keyword-Suche lassen sich weitere, passende Keywords finden und hinzufügen, welche sich kategorisch auf ein einzelnes, einzutragendes Keyword beziehen.

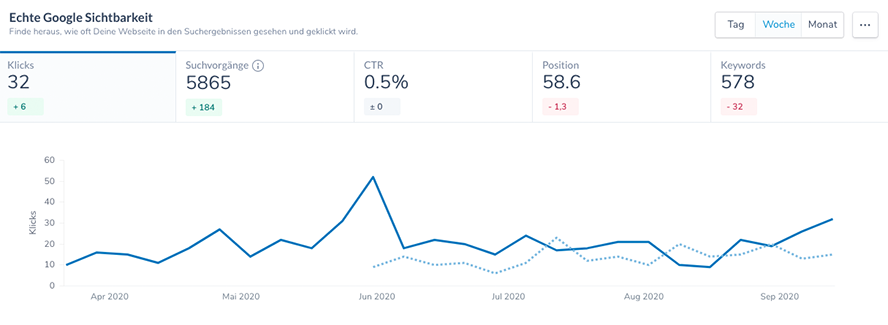

Search Success:

Im Gegensatz zum ersten Modul steht hier die Darstellung im Google-Suchsystem im Vordergrund. Sofern man die eigene Search Console verknüpft, wird an dieser Stelle mit Hilfe einer umfangreichen Keyword-Analyse die eigene Google-Performance bewertet und verbessert, wodurch man sich ein Bild über die eigenen Rankings machen kann. Zusammengefasst erhält man einen Überblick darüber, welche Rankings besonders gestiegen sind und wo Verluste zu verzeichnen sind.

Einer der Vorteile gegenüber der normalen Google Search Console ist die Tatsache, dass die Daten nach 30 bzw. 90 Tagen nach wie vor einsehbar sind, statt automatisch gelöscht zu werden. Praktisch!

Spannend finde ich außerdem die „Keyword Kannibalisierungen“-Funktion, bei welcher Ryte einem die eigenen Seiten anzeigt, die ungünstigerweise für das gleiche Keyword ranken. Somit lassen sich auch an dieser Stelle entsprechende Optimierungen vornehmen!

Weltweit setzen aktuell bereits mehr als 1 Mio. Nutzer auf Ryte (Quelle: de.ryte.com)!

Trotz der starken Konkurrenz zahlreicher, ähnlicher Tools scheint sich Ryte am Markt dennoch durchsetzen zu können und von großer Beliebtheit zu sein. Dies geht aus der weltweiten Anzahl aller derzeitigen User hervor, welche die Entwickler auf ihrer offiziellen Internetseite de.ryte.com nennen. Aktuell liegt diese bei knapp 1,2 Mio. und steigt stetig. Grund hierfür wird unter anderem sicherlich die Kombination aus SEO- und Content-Tool sein, durch welche sich Ryte von der Konkurrenz abhebt, mich persönlich hat aber insbesondere die gut strukturierte Übersichtlichkeit überzeugt.

Preise

Neben verschiedenen, kostenpflichtigen Modellen, dessen Preise sich nach dem individuellen Projekt richten, bietet Ryte Interessierten außerdem die Möglichkeit, sich zunächst einmal für einen „FREE“-Account zu registrieren. Dieser ist in seinem Funktionsumfang zwar stark eingeschränkt, bietet dem Nutzer aber dennoch einen ersten Einblick in die Möglichkeiten zur Optimierung seiner Webseite.

Kundensupport

Mit dem (mehrsprachigen) Kundensupport scheinen die Nutzer von Ryte durchweg positive Erfahrungen gemacht zu haben: So hat dieser auch unsere Anliegen schon binnen weniger Stunden bearbeiten bzw. erledigt und eine sehr freundliche und höfliche Art an den Tag gelegt.

Die Vorteile im Überblick

- Gut strukturierte und aufgearbeitete Analyse-Ergebnisse für eine optimale Beurteilung der eigenen Webseite

- Grafische Dar- und Hilfestellungen zum einfachen und unkomplizierten Verständnis der Analyse-Daten

- Schnelle und einfache Bedienung für eine angenehme Übersichtlichkeit der zahlreichen Funktionen

- Google Analytics Daten bleiben einsehbar

- Kombination aus SEO- und Content-Tool

- Kostenlose „FREE“-Mitgliedschaft

- Mehrsprachiger, kompetenter und freundlicher Kundensupport

Fazit

Ryte ist ein nützliches Tool, um Webseiten zu untersuchen, Fehler zu analysieren und mithilfe der Reports technische Fehler strukturiert auszubessern. Angefangen als onpage.org ist ryte ein sehr mächtiger Toolbaukasten geworden.

Ein regelmäßiger Crawl, zum Beispiel wöchentlich, erfasst die Änderungen und listet offene ToDos auf. Die ausführliche Dokumentation zum Fortschritt der Änderungen hilft in der Kommunikation mit der IT und weiteren Beteiligten.

Achtung: Die erkannten “kritischen Probleme” und die prominenten Prozentwerte zum Optimierungsgrad sollten immer mit nüchternem Blick geprüft werden. Die Reports müssen – wie immer – priorisiert werden, um sich nicht in Verliebtheit zur Kleinseorei zu verlieren.

Eine 100% Optimierung ist kaum zu erreichen, bzw. müssen die erkannten Fehler immer gewichtet werden. Ein echter 404 Fehler ist wichtiger als ein zu langer Seitentitel oder Meta-Beschreibungen, die Google meist von selber umschreibt.

Tolle Funktionen, die Spaß machen. In der Agenturarbeit sind nützliche Features wie Überwachung der Robots.txt eine tolle Hilfestellung. Bei Änderungen erhalten wir sofort eine E-Mail:

“Wir wollen dich kurz informieren, dass die robots.txt Deines Projektes www.projektname.de geändert wurde. Bitte wirf einen Blick auf die Änderungen und kontrolliere ob alles ok ist.

Legende: Grau = Wurde entfernt & Fett = Wurde hinzugefügt”

Zum Test von ryte empfehle ich eine kurze Einführung über ein Webinar oder eine kostenlose zeitlich begrenzte Demo der Software. Eine Kündigung nach Testphase ist nicht erforderlich (Stand März 2023).

Touch-Elemente sind die Bereiche einer Webseite, mit denen Benutzer auf Touch-Geräten interagieren können. Schaltflächen, Links und Formularelemente haben Touch-Elemente.

Touch-Elemente sind die Bereiche einer Webseite, mit denen Benutzer auf Touch-Geräten interagieren können. Schaltflächen, Links und Formularelemente haben Touch-Elemente.